Segmentacja obrazu

Segmentacja obrazu (ang. image segmentation) – proces podziału obrazu na części określane jako obszary (regiony), które są jednorodne (homogeniczne) pod względem pewnych wybranych własności. Obszarami są zbiory pikseli (punktów). Własnościami, które są często wybierane jako kryteria jednorodności obszarów są: poziom szarości, barwa, tekstura.

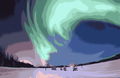

Obraz po uruchomieniu k-średnich, k = 16

Cel i znaczenie segmentacji obrazów

Otrzymany w wyniku segmentacji obraz jest uproszczony w stosunku do obrazu poddanego segmentacji — obraz taki nie zawiera wielu szczegółowych informacji występujących w oryginalnym obrazie. Podobna sytuacja zachodzi także w przypadku wykrywania krawędzi w obrazie.

- Przykład

- Dla obrazów achromatycznych obraz po segmentacji nie zawiera informacji o poziomie szarości poszczególnych pikseli należących do obszarów, ta szczegółowa informacja jest zwykle zastępowana informacją o średnim poziomie szarości pikseli należących do danego obszaru.

Decyzja o tym czy dany rodzaj informacji występującej w obrazie jest istotny czy nieistotny powinna być podejmowana z uwzględnieniem potrzeb wynikających z dalszego wykorzystania wyników segmentacji. Uproszczony w wyniku przeprowadzenia segmentacji obraz jest znacznie łatwiejszy do dalszego przetwarzania lub analizy, dlatego też segmentacja zwykle poprzedza zastosowanie wielu algorytmów rozpoznawania i analizy obrazów. Należy zwrócić uwagę na fakt, że wybór określonej metody segmentacji powinien być uzależniony od celu w jakim jest ona prowadzona. Niewłaściwe przeprowadzona segmentacja praktycznie uniemożliwia prawidłowe przeprowadzenie dalszych etapów analizy obrazów, a tym samym może prowadzić do podejmowania błędnych decyzji na podstawie analizowanych obrazów.

- Przykład

- Niech celem stosowania analizy obrazów będzie policzenie liczby jabłek widocznych na obrazie. Prawidłowo przeprowadzona na potrzeby tego zadania analizy segmentacja obrazów powinna doprowadzić do tego, że obraz po segmentacji zawierać będzie tylko obszary prezentujące poszczególne jabłka oraz tło, nie powinny zostać wyróżnione obszary reprezentujące odblaski światła na jabłkach oraz cienie rzucane przez poszczególne owoce. Niespełnienie tego warunku znacznie utrudni proces analizy ponieważ zamiast policzenia tylko obszarów reprezentujących jabłka, konieczne będzie odrzucenie obszarów, które reprezentują odblaski lub cienie.

Segmentacja obrazów uważana jest przez wielu autorów za jedno z najtrudniejszych i równocześnie najważniejszych zadań jakie występują widzeniu komputerowym i widzeniu maszynowym(ang.).

Klasyfikacja metod segmentacji obrazów

Klasyfikacja metod segmentacji ze względu na rodzaj informacji wykorzystywanej w czasie segmentacji:

- metody punktowe

- progowanie – np. poprzez dobór progu na podstawie histogramu obrazu, wynikiem jest uzyskanie obrazu binarnego,

- klasteryzacyjne – tworzenie obszarów na podstawie cech przypisanych do pikseli w wyniku stosowania algorytmów klasteryzacji (grupowania),

- metody krawędziowe – stosowanie tego typu metod wymaga zastosowania któregoś z algorytmów wykrywania krawędzi

- metody obszarowe

- metody hybrydowe – wykorzystujące dwie lub więcej z powyższych metod np. rozrost obszarów z wykorzystaniem informacji o przebiegu krawędzi.

Zobacz też

- grupowanie

Bibliografia

- H. D. Cheng, X. H. Jiang, Y. Sun, Jingli Wang, Color image segmentation: advances and prospects, Pattern Recognition, 34 (2001) pp. 2259–2281, http://dx.doi.org/10.1016/S0031-3203(00)00149-7.

- Rafael C. Gonzalez, Richard E. Woods, Digital Image Processing, Addison-Wesley Publishing Company, 1992, ISBN 0-201-50803-6.

- Ryszard Tadeusiewicz, Rozpoznawanie obrazów. Państ. Wydaw. Naukowe, Warszawa 1991. Seria: Problemy Współczesnej Nauki i Techniki. Informatyka.

- Ryszard Tadeusiewicz, Komputerowa analiza i przetwarzanie obrazów. Wydawnictwo Fundacji Postępu Telekomunikacji, Kraków 1997. Seria: Społeczeństwo Globalnej Informacji.

Media użyte na tej stronie

Zorza polarna widziana nad jeziorem Bear, przy amerykańskiej bazie sił powietrznych Eielson

File:Polarlicht 2.jpg reduced to 16 colors using the k-means algorithm. Implemented in MATLAB as follows:

- Read in source image.

- Convert to 3-dimensional matrix of [y-value, x-value, rgb] using imread. Each entry is an integer between 0 and 255 representing the value of the color indicated by rgb at (x, y).

- Reduce linear resolution 8 times by averaging the values in each 8x8 matrix block (for faster processing).

- Run k-means (self-implemented) for 20 iterations with k = 16, obtaining 16 colors which are the centroids of each cluster.

- For each pixel in the original image, replace its value with the closest color based on Euclidean norm of RGB.